Kleine Kompositionslehre der elektronischen Musik

, November 1991

(verbergen)

1

Die Lehre von der Komposition Elektronischer Musik im Zusammenhang

von Tradition und Geräten

1.1

Drei Familien von Verfahren

1.2

Primzip der (möglichst) Unbeschränkten Kompatibilität

1.3

Gezielter Fehlgebrauch

2

Als neuer Akteur: Der Digitalrechner

2.1

Erstens: Interoperabilität; Integration, Vermittlung. Datenformate

2.2

Integrierte Wokrstations, z.B. im AUDIAC-Projekt

2.3

Zweitens: Erweiterbarkeit und Adaptierbarkeit

2.4

Drittens: Auswirkungen, Änderungen des Denkens

(verbergen)

(verbergen)

Was wir heute Geschichte der elektronischen Musik nennen und was sich über ein Jahrhundert lang aufgebaut hat, ist eine historische Entwicklung, gekennnzeichnet durch ein hohes Maß an Innovativkraft und ein geringes Maß an Systematisierung.

Die grundlegenden Anforderungen an eine akademische und den Kriterien wisssenschaftlicher Ausbildung genügende Lehre von der Komposition elektronischer Musik sind jedoch systematische. An all den Orten, an denen die elektronische Muusik Einzug in die Akademien gehalten hat, sind folglich qualitativ neue Bedingunngen fur die musikalische Produktion und die ästhetische Forschung eingetreten. Anhand konkreter Beispiele aus der Arbeit des Instituts fur Computermusik und elektronische Medien (ICEM) an der Folkwang-Hochschule in Essen soll gezeigt werden, auf welche Weise sich Komponisten innerhalb einer sorgfaltig geplanten und vor· bereiteten Arbeitsumgebung verhalten, wie sie mit >vorgefertigten< technischen Produkten produzieren, gegen sie reagieren und was die Voraussetzungen dafur sind, daß im Rahmen des Hochschulbetriebs Innovation stattfinden kann.

Zum Abschluß soll diskutiert werden, welche Konsequenzen aus diesen Errfahrungen für die weitere Entwicklung zu ziehen sind, besonders was den Einnsatz der in Zukunft dominierenden digitalen Medien angeht.

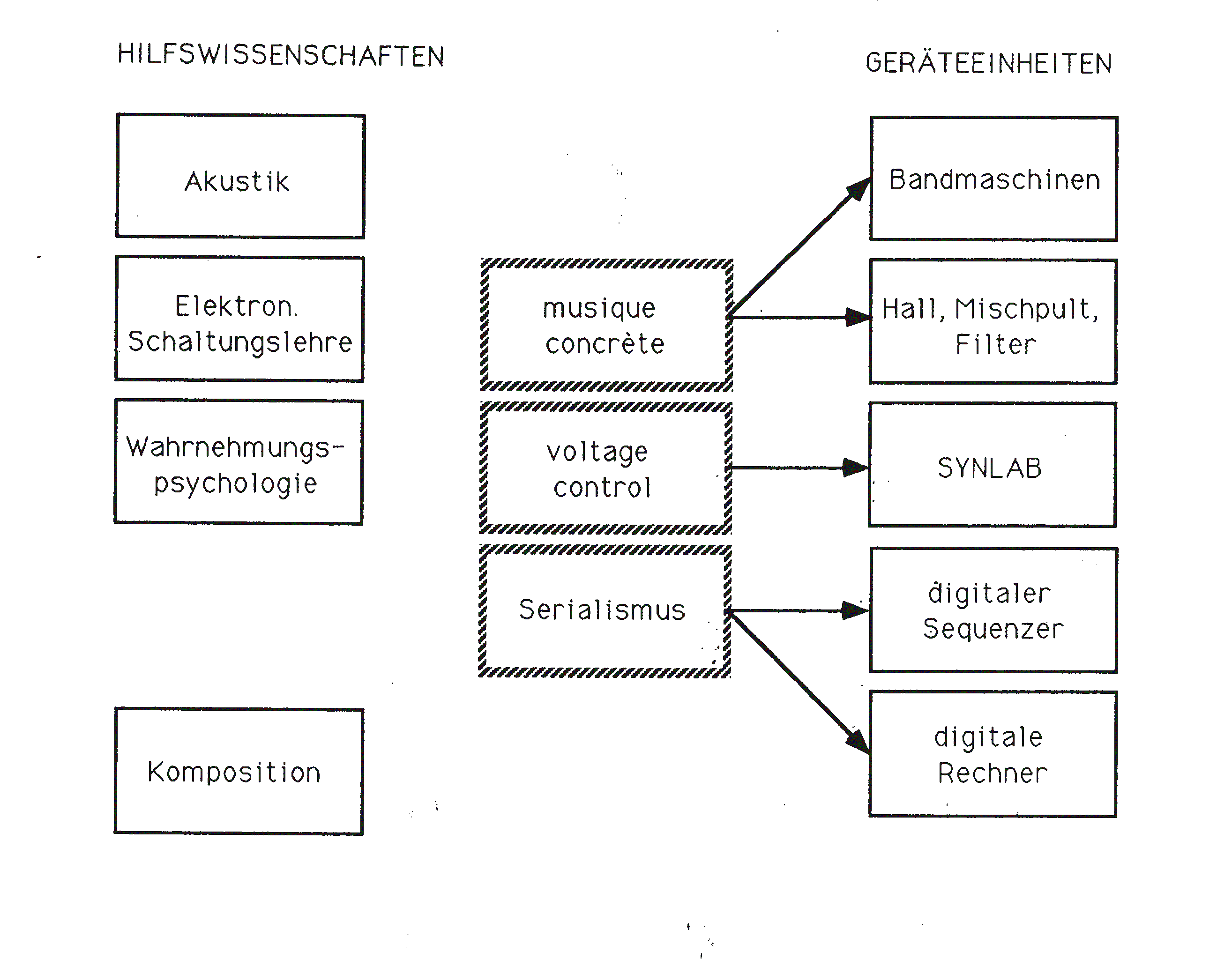

Wir möchten zunächst von der Lehre von der Komposition elektronischer Musik einen vereinfachenden Abriß geben, welchen wir dann unmittelbar in Beziehung setzen zu den einzelnen Geräteeinheiten im Studioe des ICEM, siehe dazu Abbildung 1. Die Lehre von der Komposition elektronischer Musik läßt sich grundsätzlich aufteilen in Nebenfacher, also grundlegende Kenntnisse in den Hilfswissenschaften einerseits und die eigentliche »Ästhetische Lehre« andererseits. Zu den Nebenfachern gehören: Akustik (hierin Raulmkusstik, Lautsprecherkunde, Instrumentenkunde, Phonetik, etc.), elektronische Schaltungslehre, Wahrnehmuügspsychologie, Komposition. (Für das Studium der elektronischen Komposition an der Folkwang-Hochschuleist ein Studium der Komposition Voraussetzung . In der Tat lassen sich die klassischen Satztechniken von beispielsweise Bachschem Kontrapunkt über Wagnersche Harmonik bis zu Nonoscher Reihentechnik als »von innen betrachtete«, also angewandte und mechanisierte Wahrnehmungspsychologie auffassen. Bei dieser Betrachtungsweise sieht man kurzzeitig davon ab, daß alle Satztechniken natürlich auch soziale, historische und transzendentale Aspekte bieten.)

Die Lehre von der eigentlichen elektronischen Ästhetik vollzieht sich im ersten Schritt durch die Rezeption, Analyse und Kritik existierender Objekte und Konzepte (also abgeschlossener Werke wie Tonbandstücke, Partituren oder Computer-Programme einerseits und Aufsätze, Programmtexte und Vorträge andererseits). Dabei sollen, sowohl unter Berücksichtigung der historischen Siituation der Entstehung als auch unter deren Abstraktion, die ästhetisch-rezeptionstechnischen, die inhaltlich-weltanschaulichen und die technologisc-produktionstechnischen Aspekte angemessen herausgearbeitet und in Beziehung gesetzt werden. Beispiele aus verschiedensten Epochen und verschiedensten Stilrichtungen können einer solchen Analyse unterzogen werden, welche dem Studenten helfen soll, seine eigene ästhetische Position sinnvoll zu bestimmen.

Dazu jedoch reicht die Analyse nicht aus. Vielmehr müssen die am historischen Beispiel vorgeführten Techniken in praktischen Übungen nachvollzogen werden. Nur so können die ästhetischen und produktionstechnischen Implikationen der verschiedenen Verfahren wirklich erlebt und begriffen werden, z.B. in bezug auf die Wahrnehmbarkeit von Strukturen, das Maß der Beeinflußbarkeit von Prozessen, das Maß der Vorhersagbarkeit von Ergebnissen, das Hervortreten von unerwünschten Nebeneffekten in der Rezeption, etc.

Diese unmittelbare praktische Verifikation von theoretischen Erkenntnissen und Vorstellungen unterstützt die »Hardware« des elektronischen Studios des ICEMin besonderer Weise dank eines zugrundeliegenden, durchgängig aus kompositorischen Erfahrungen hervorgegangenen Konzeptes. Dieses Konzept läßt sich charakterisieren durch die beiden Schlagworte »Modularität« und »Kompatibilität«. Diese gelten sowohl auf der technischen Ebene der installierrten Geräte als auch auf der ästhetisch-inhaltlichen Ebene des kompositorischen Denkens.

cultec_picts/cultecfig01.png

|

| Abbildung 1: Die drei Bereiche elektronischer Musik und ihre Gerätschaften |

Die Theorien und Verfahren der elektronischen Musik lassen sich grob in drei Familien einteilen, die auch als solche Gegenstand von Forschung und Lehre sind. Man kann sie mit den Stichworten bezeichnet: musique concrète, volltage-cntrol, Serialismus. (Siehe die mittlere Spealte in Abbildung 1. Diese Worte sind normalerweise Namen für bestimmte historiische Epoche, welche den drei grundlegenden Denkformen enttsprechen und hier pars pro toto als griffige Kürzel gewählt wurden.)

Der mit musique concrète bezeichnete Bereich enthält die "analytischen" Klanggeneriereungen. Diese sind (a) "subtraktive Synthese", also Filtrierungen, Amplituden-Demodulation und -Modulation, Produktmodulation, und (b) die Tonbandtechniken, also Schnitt und Montage, Transposition, Schleifenbildung, etc.

Der mIt "voltage-control" bezeichnete Bereich ist der Einsatz ses Analogrechners, also eines es modularen analogen spannungsgesteuerten Synthesizers. Die Lehre re vom Einsatz des Analogrechners beginnt bei der reinen Klanggenerierung, wie also bestimmte Spektren und Spektralverläufe durch die Kombination und Verschaltung der einzelnen Module erzeugt werden. Sie endet bei dem Bau großer, rückgekoppelter kybernetischer Modelle, die selbsttätig Strukturverläufe über mehrere Minuten hin generieren und so großformale Entwicklungsteil qua Schaltung definieren.

Das Stichwort "Serialismus" bezeichnet ein Denken, das davon ausgeht, daß musikalisch sinnvolle Materialdispositionen, Strukturverläufe und Formgliedeerungen aus Reihen, Formeln und mathematischen Verfahren ableitbar sind. Obwohl diese Verfahren seit langem erprobt und bewährt sind (Webern Stockkhausen, Boulezsind einige bekannte Vertreter), indem die Komponisten die Algorithmen "zu Fuß" auf dem Papier ausführten, ist diese Ausführung naturgeernaß dem digitalen Rechner angemessen. In diesen Bereich gehört auch die Erfahrung, daß man die Werke z.B. der barocken oder klassischen Periode durchhaus mit mathematischen Modellen analysieren und so Formeln ableiten kann, die bei der aktuellen Komposition als Materialgeneratoren wertvoll sein können.

Diesn drei Großgruppen und die unter ihnen zusammenfasste Satztechniken haben jeweils ihre spezifischen ideolotgischen, rezeptionsästhetischen und technologischen Implikationen. Den drei Gruppen entsprechen drei Funkktionseinheiten im Studio des ICEM. Grob zugeordnet werden können ...

Das grundlegende Konzept von »Kompatibilität und Mod~larität« jedoch errweitert die Grenzen obiger Zuordnung: Grundsätzlich kann Jede der FunktIonsseinheiten in jedem Syntheseverfahren eingesetzt werden. Zum Beispiel:

|

FEHLT NOCH !! |

| Musikbeispiel 1: Ausschnitt aus der "Manahttan-Suite" von Martin Schulz und dem Verf. |

Der produktiven Phantasie sollen im Studio der Folkwang-Hochschule möglichst keine technischen Grenzen gesetzt werden. Dies wurde erreicht durch das mit größtmöglicher Strenge durchgehaltene, simple Grundprinzip: Jeder Aussgang kann mit allen Eingängen verbunden werden.! Was auf technischer Ebene als primitive »pin-to-pin« Kompatibilität erschemt, ist jedoch nur. Ausprägung eines zugrundeliegenden konsequenzenreichen ästhetlscsehen Prinzips. Dieses kann man beschreiben mit den Worten: Keme Satztechhnik, keine Verfahrensweise ist a priori bevorzugt oder verpönt, sondern jede angewandte Maßnahme muß ihre Berechtigung beweisen im Rahmen des speeziellen.ästhetischen Kontextes eines individuellen Werkes. Diesem Gedanken liegt zugrunde ein auf langjahrite Erfahrung gestütztes Vertrauen auf die "strukturbilndenden Tendenzen der Arbeitsökonomie" im Kmapf mit den Widerständen der Technik.

Jener experimentelle, ja spielerische Umgang mit der Technik, jenes gefahrlose Alles-mit-allem-verbinden-Können (nur nicht zwei Ausgänge !-). die Forderung nach unbegrenzter Kompatibilität mögen manchem sogar »verspielt« erscheiinen. Das sind sie nicht. Die Erfahrung der Arbeit im Studio zeigt nämlich: Mag der Ausbauzustand ständig wachsen, mögen noch so viele neue und leistungsfähige Module dazukommen, die Arbeit des Komponisten, der seine Vorstellungen genau realisieren will, ist immer auch eine Arbeit gegen die Geräte. Mag auch jedes Gerät fast alles können, es kann doch nie das, was es gerade soll. Dafür aber kann das ein anderes Gerät, welches jedoch nie dafür entworfen worden ist.

Selbstverständlich besteht auch in der elektronischen Musik, wie in jeder Kunst, ästhetische Reife und künstlerische Bedeutung in der Beschränkung auf das Weesentliche und die letztlich minimal notwendigen Mittel. Dies ist jedoch kein Arrgument dagegen, dem Lernenden, Forschenden und Produzierenden die größtmögliche Fülle an Geräten, Verfahrensweisen und Kombinationsmöglichkeiten a priorizur Verfügung zu stellen. Ganz wie der »klassische« Instrumentalkompoonist wissen muß, daß die leeren Saiten der Streicher, die Pedaltöne der Blechbläser und das kleine h der Flöte ganz eigene Qualitäten haben, verglichen mit allen anderen Tönen, die auf diesen Instrumenten spielbar sind, so muß der elektroniische Komponist einen Filter mit überhöhtem "Q" als Tongenerator benutzen können, eine Kombination aus Sägezahngenerator und Schmitt-Trigger als Rhythmus- und Pattern-Generator, eine Kombination aus Tonbandmaschine und Amplitudenmodulator als Analysegerät für die Erkennung rhythmischer Gruppen.

|

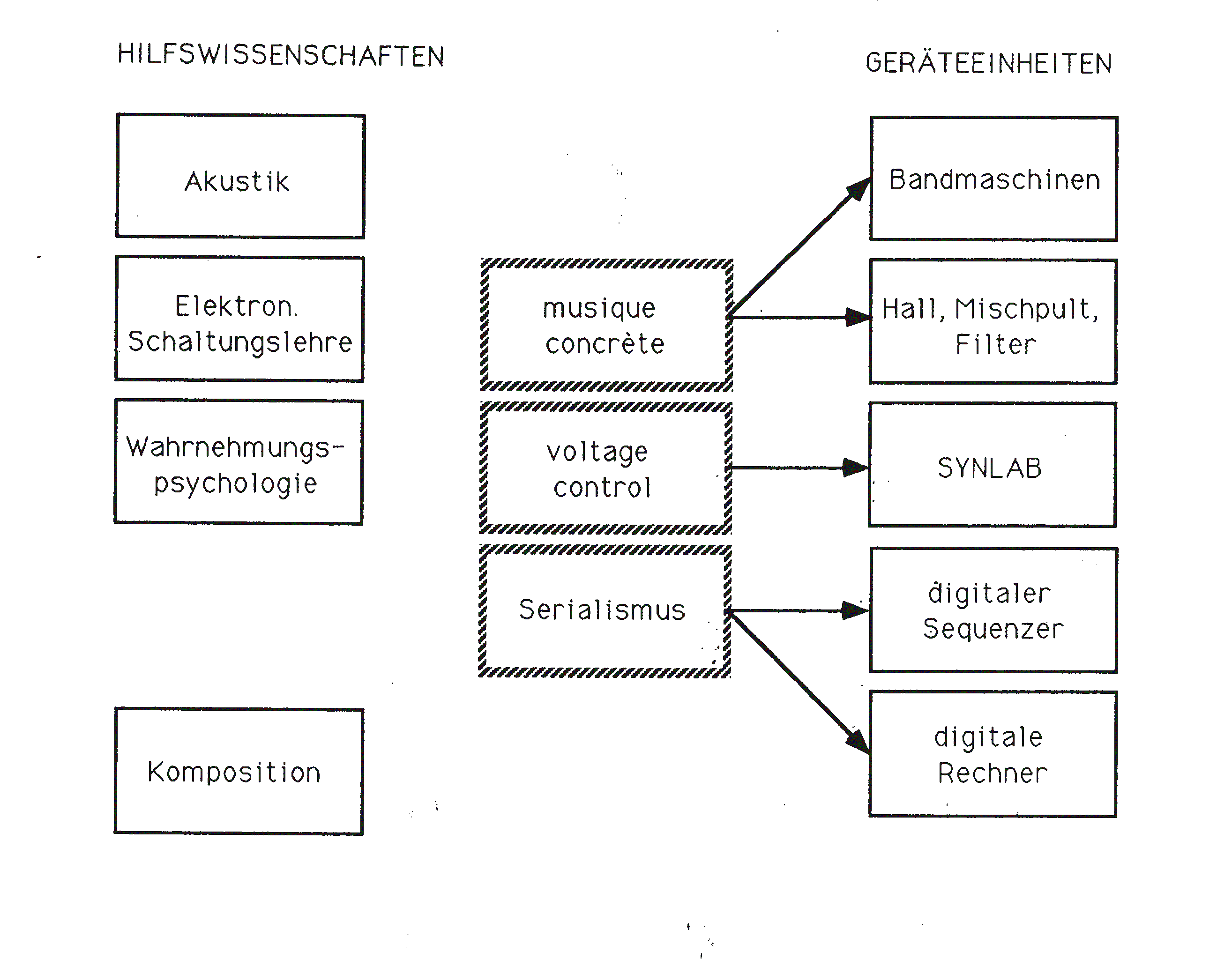

| Abbildung 2: Die SYNLAB Schaltung zum Klangbeispiel "Macbeth-Suite" |

Eins der frühen elektronischen Werke des Verfassers, die Macbeth-Suite, kann dies verdeutlichen. Hier werden primär für Audio-Betrieb ausgelegte Geräte im Subaudiobereich, also niederfrequent, eingesetzt werden, und umgekehrt.

Die Schaltung zeigt Abbildung 2. Vier Puls-Generatoren werden niederfrequent eingesetzt mit einer Periodenndauer von einer Sekunde und darüber. Statt wie sonst einen hörbaren Ton erzeuugen sie unhörbare Steuerspannungen. Diese werden aufaddiert, und da sie geegeneinander schweben, erzeugen sie eine melodische Kurve mit maximal sechhzehn verschiedenen Tonstufen. Diese Steuerspannung wird auf einen »normal« betriebenen, also einen hörbaren Ton liefernden Funktionsgenerator gegeben. Anstatt direkt hörbar zu werden, steuert dieser vier sogenannte »ADSR«s, also Hüllkurvengeneratoren, die dazu gebaut sind, subaudio betrieben zu werden und die Ein- und Ausschwingvorgänge eines akustischen Ereignisses zu formen. Diese ADSRs, die normalerweise maximal ein paar mal pro Sekunde angestoßen werrden, werden also hier mit einer hörbaren Schwingung angestoßen, ein paar hundertmal pro Sekunde.

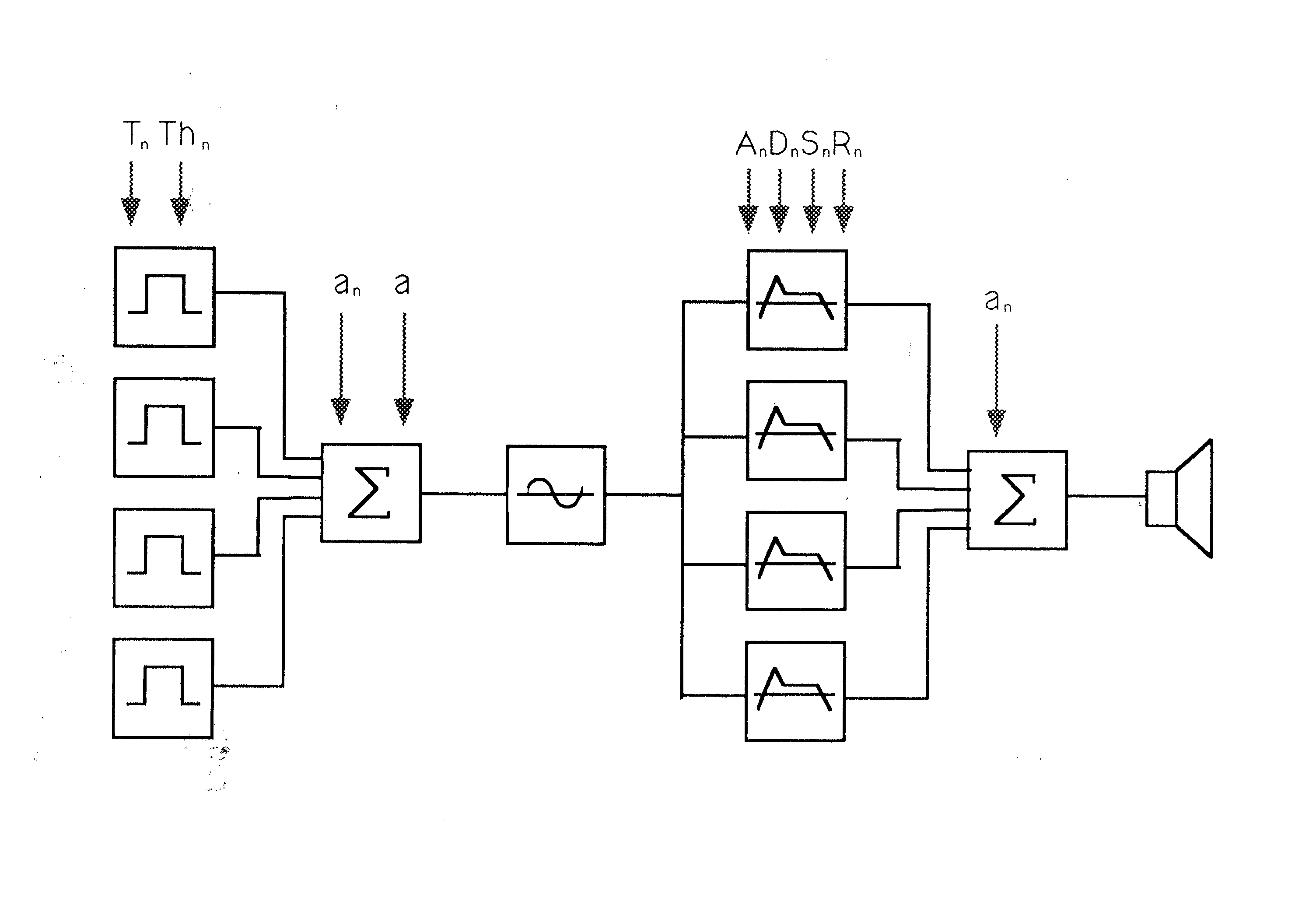

Dadurch wirken sie als subharmonische Teiler. Sie strukturieren mit einfachen Mitteln und komplexem Ergebnis den wahrgenommeenen Tonraum, da ihre charakteristischen Kurvenformen mit absoluten Dauern eingestellt werden und diese Dauern, abhängig von der taktenden Frequenz, nur jeden n-ten Impuls als Kurvenstartpunkt akzeptieren. Deshalb teilt jeder ADSR auf seine Weise unterschiedliche Frequenzen durch unterschiedliche Faktoren, vgl. Abbildung 3. Die Summe der vier ADSRs gibt so unterschiedlichen Tonhöhen jeweils unterrschiedliche Klänge, und zwar nach einer Logik, die der funktional-harmonischen Tonraumstrukturierung in der Wahrnehmung ähnelt.

|

| Abbildung 3: Schwingungsformen an den ADSR-Ausgängen im Klangbeispiel "Macbeth-Suite" |

Der "strukturellen Schwebung« zwischen Teilungsspektren und Tonhöhen entspricht die Schwebung der tonhöhenbestimmenden Steuerspannungen selbst. Das von der Steuerspannung vor seiner subharmonischen Teilung aufgeespannte Spektrum (die Tonhöhenmenge) ist ebenfalls ein global steuerbarer Paarameter, da die Addition der vier einfachen Grundschwingungen, sowohl was den Hub der einzelnen Schwingung als auch was den Gesamthub der Skala anngeht, regelbar ist.

Interessanterweise aber dominiert die durch die subharmonische Teilung innduzierte Wahrnehmung eines funktional gewichteten Raumes so stark, daß auch die Komprimierung und Verstimmung der Grundfrequenzen den Eindruck von Ausgewogenheit und funktional-tonikaler Bestimmtheit nicht zu neutralisieren verrmag.

|

FEHLT NOCH !! |

| Musikbeispiel 2: Ausschnitt aus der "MacBeth-Suite" |

Zwischen menschlichem Wollen, hier: die ästhetische Vorstellung, und den Möglichkeiten der jeweils aktuellen Technologie besteht ein grundlegender Widerspruch. Dieser entspricht der künstlerischen Arbeitsweise ihrem Wesen nach - ja, er ist für diese sogar durchaus konstitutiv. So wie das weiße Licht sich nur an einem Sprung in einer Glasscheibe in seine Farben bricht, so entzündet sich an diesem Widerspruch die menschliche Kreativität. Jede neue Technologie kann diesen Widerspruch immer nur im dialektischen Sinn aufheben, d.h. sein Erscheinungsbild verändern und den Ort seines Auftretens verschieben.

Die entscheidende technologische Neuentwicklung des letzten Jahrzehnts war die Erfindung und massenweise Verbreitung leistungsfähiger Mikroprozesssoren. Die konsequente und systematische Anwendung dieser kann im Bereich von musikalischer Produktion und Komposition tatsächlich neue Quaalitäten schaffen. Von der elektronischen Massenindustrie wurde bereits eine neue soziale Quaialität geschaffen, da digitale Geräte die altbekannten Effekte auf wesentlich preiswertere Art hervorbringen können, und somit einem explosionsartig vergrößerten Kreis von Anwendern erschwinglich sind. In Ergänzung dazu befaßt sich die akademische Forschung und Entwicklung naturgemäßer Weise vorrangig mit den inhaltlichen Neuerungen, die von der Anwendung der Digitalt hnik in den Gesamtzusammenhang der ästhetischen Produktion eingebracht werden.

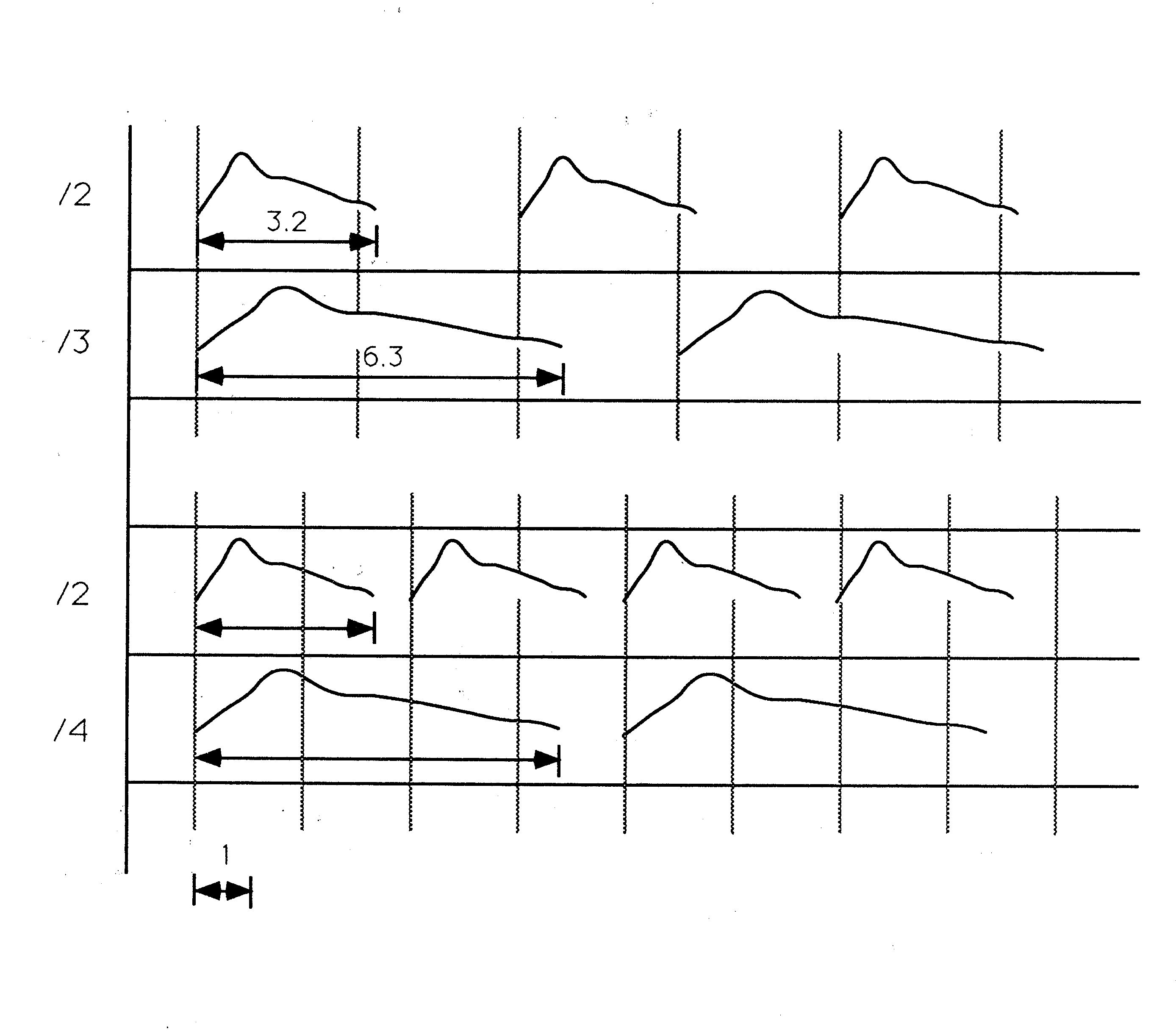

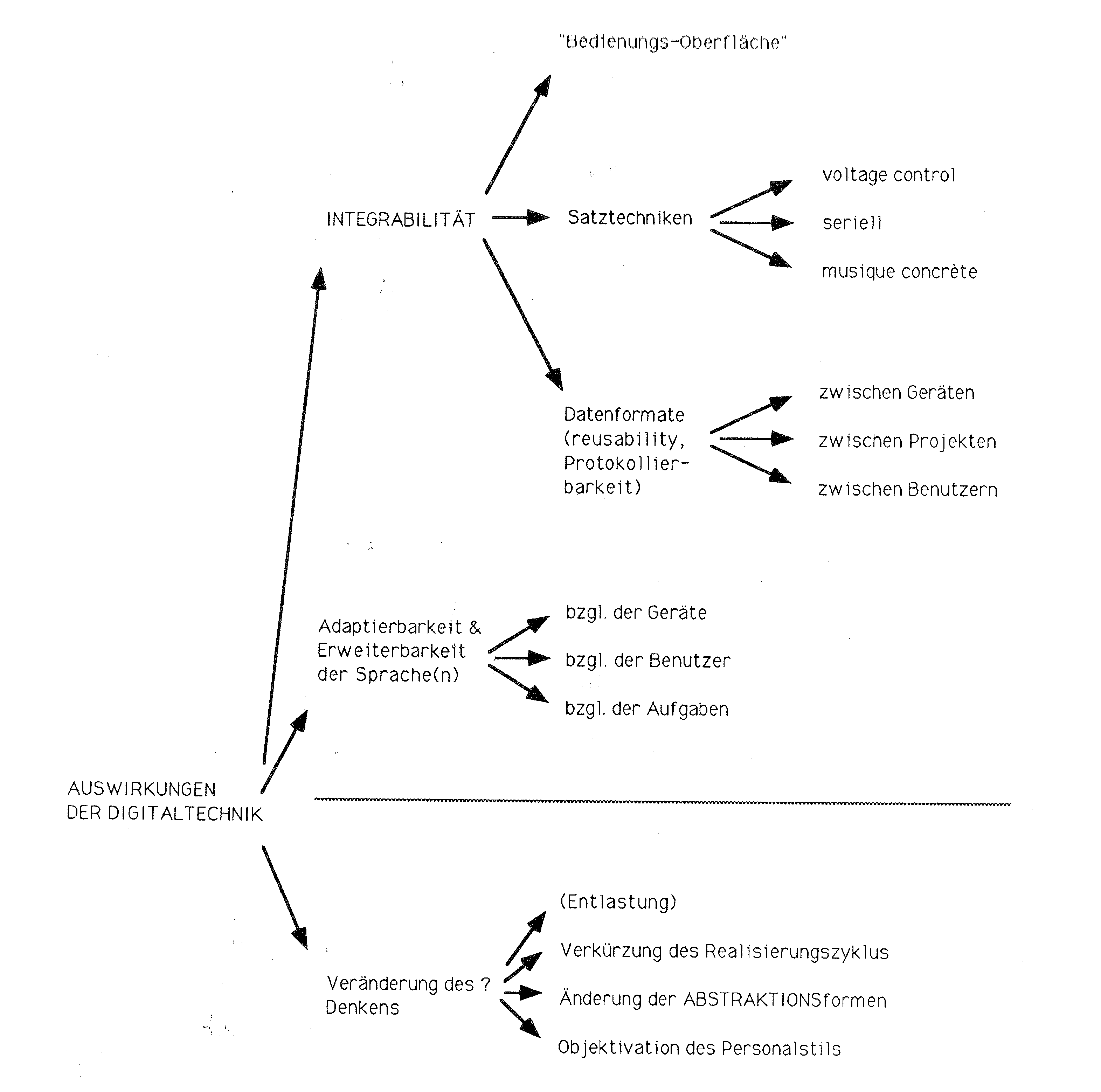

Eine Untersuchung, :aufbauend auf den Erfahrungen mit den "klassischen" elektronischen Satztechniken, zeigt, daß auf allen Ebenen der Produktion die Digitaltechnik zunächst einmal quantitativ eiweiterte Möglichkeiten des Denkens und Handelns mit sich bringt. Aus diesen neuen Quantitäten folgen sowohl neue Qualitäten des kompositorischen Denkens als auch neuartige Probleme und Herausforderungen. Wir haben versucht, diese Auswirkungen in folgendem Schema (Abbildung 4) zu klassifizieren, welches als Gliederung der abschließenden Darlegung dienen soll.

|

| Abbildung 4: Mögliche Auswirkungen des zunehmenden Gebrauches der Digitaltechnik |

Die ersten beiden Gruppen beinhalten die Möglichkeiten der digitalen Datenverarbeitung, bezogen auf die bekannten und hergebrachten Verfahren des musikalischen Denkens. Die dritte Gruppe versucht, die wahrscheinlich zu errwartenden grundsätzlich neuartigen Denkformen zu extrapolieren, ausgehend von den bereits geewonnenen Erfahrungen aus den praktischen Experimenten.

Die digitale Informationsverarbeitung, welche alle Denk- und Datenoperationen auf die streng begrenzte Menge inhaltlich primitiver Operationen eines digitalen Prozessors abzubilden zwingt, fordert ein hohes Maß an Abstraktionssleistung seitens der erbauenden Ingenieure - sowohl in der vorhergehenden Syystemanalyse der Anforderung als auch in der Planung und der Codierung einer digitalen Maschine. Aus den somit vom Material bedingten Notwendigkeiten zu modularer und generischer Programmierweise und aus dem auf allen Ebenen eines digitalen Systems noch durchschimmernden grundlegenden Abstraktionssvorgang folgt ein von älteren Technologien nicht erreichtes Maß an integrativer und adaptiver Kraft.

|

| Abbildung 5: Mögliche zentrale Stellung des Digitalrechners |

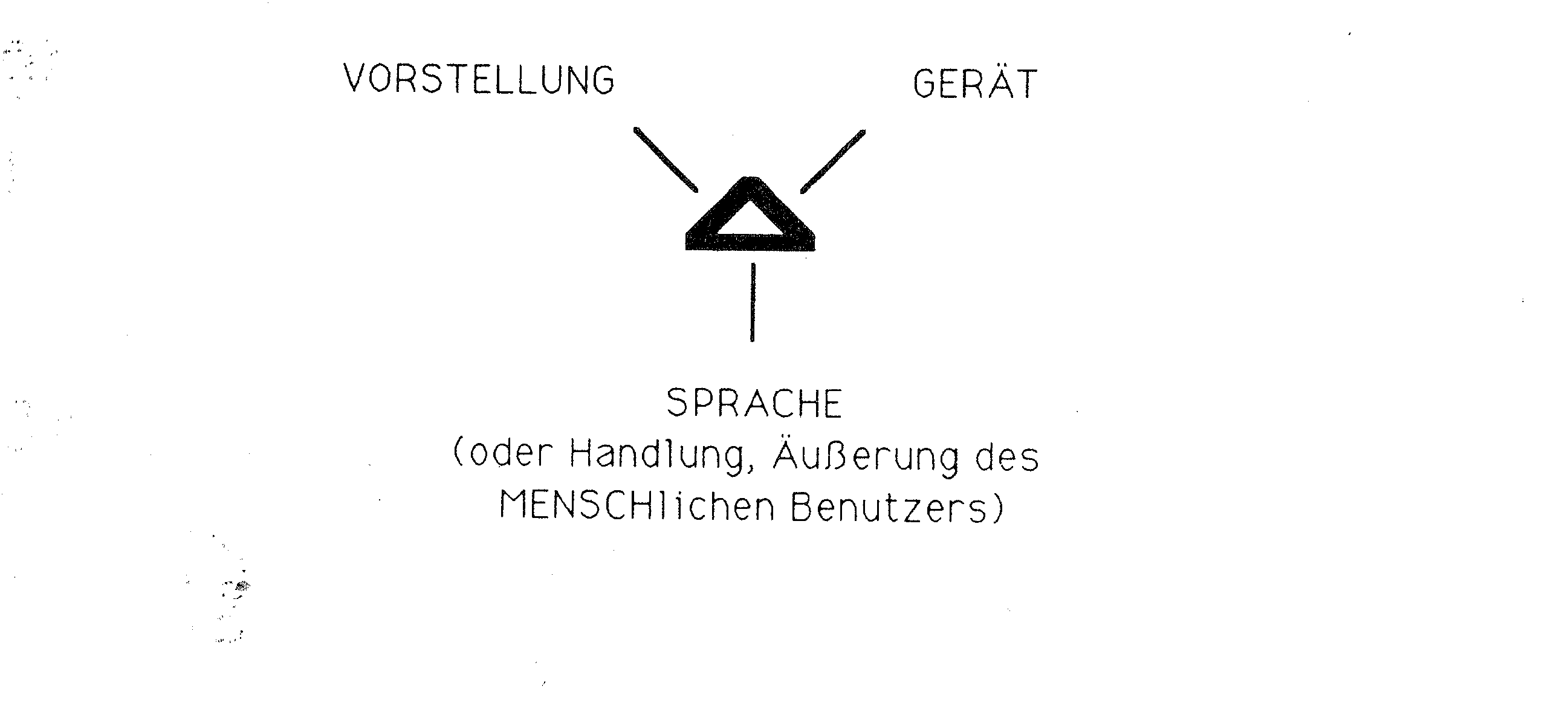

Diese integrative Kraft weist einem digitalen System als natürlichem Ort seiiner Anwendung die Mitte eines Dreiecks zu (Abbildung 5), dessen Ecken gebildet werden durch die musikalisch/ästhetische Vorstellung des Musikers zum einen; durch die verschiedenen Geräte, Funktionseinheiten, Technologien des Studios zum anderen - und durch die Formen der menschlichen Äußerungen und Wahrnehmungen zum dritten, also durch die Sprache des produzIerenden Musikers, welche ausgangsseitig das Bewegen von Schiebereglern, das Drücken von Tasten, das Bespielen einer Klaviatur, :das Schreiben von Sätzen einer Programmierspraache, die bekannten Mittel grafischer Eingabe, eingangseitig das Beobachten graafischer Ausgaben, angezeigter Zahlenwerte und das Hören beinhalten.

An dieser Stelle, im Zentrum dieses Dreiecks, kann und muß die Digitaltechhnik die nur von ihr zu leistenden grundlegenden Aufgaben von Integration und Vermittlung wahrnehmen. Dies ist u.E. die wichtigste und erfolgversprechenddste zukünftige Aufgabe der digitalen Technologie.

Die integrative Kraft wird erstlich wertvoll in dem großen Bereich des sog. »human interfacing«, also der Mensch/Maschine-Schnittstelle. In der Tat hatte im klassischen elektronischenStudio jeder Gerätetyp eine eigene Sprache zu seiner Bedienung. Diese Sprache bestand z.B. beim modularen analogen Synthcsiizer in den einzelnenspannungskontrollierten Eingängen und der internen Defiinition, welche angelegte Spannung welchen Effekt auf welchen Parameter hat; bei den Tonbandmaschinen in der Betätigung der Tasten oder dem unmittellbaren Bewegen der Bandwickel, bei den nicht-spannungsteuerbaren Effektgeräten in den Stellungen der Schalter und Regler, etc.

Es ist ohne Zweifel eine Entlastung des produzierenden Musikers von störennden Nebenbedingungen, wenn er von einem Platz aus mit einer einheitlichen Kontrollsprache und einheitlicher Protokollierung und Rückmeldung seiner Befehle möglichst alle Geräte steuern und abfragen kann. Dies ermöglicht erst die Digitaltechnik. Diese Integration ist für die verschiedenen Bandmaschinen in allen Studios durch die sog. SMPTE-timecode Technik seit einigen Jahren verwirklicht.

Im Gegensatz dazu ist das Problem der sprachlichen Integration durch das Aufkommen der handelsüblichen digitalen Synthese- und Effektgeräte durchhaus vergrößert worden. Die weithin divergierenden, auf primitivsten Hardware-Einrichtungen (z.B. einem LCD-Display von zwei Zeilen und einer hexadeziimalen Tastatur) installierten Benutzerschnittstellen, die für jedes neue Gerät ein neues Handbuch zu lesen zwingen, sind ein eminenter Rückschritt verglichen mit den kompatiblen Modulen des analogen Synthesizers.

Ein wirklich integrales digitales Studio-System hat auch die Aufgabe, hier qua Fernsteuerung eine einheitliche, protokollierbare, automatisierbare und komfortable Bedienungsoberfläche zu schaffen. Durch den zunehmenden Einnsatz digitaler Einzelinstrumente darf nämlich nicht jene quasi-totale Konnektivität des experimentellen Studios verloren gehen, die es ermöglicht, alle Geräte auch außerhalb ihrer Standardsituation zu verwenden und somit ästhetisch, satztechnisch und praktisch ganz individuelle Beeinflussungsmöglichkeiten auf musikalische Prozesse zu realisieren. Ganz im Gegenteil muß diese Konnektiviität erweitert werden.

Ein Beispiel für den gezielten Mißbrauch eines digitalen Gerätes im hybriiden Studiokontext: Um eine mehrminütige exponentielle Steuerkurve zu realiisieren, wurde der digitale Sequenzer mit einer linear fallenden Folge von Zahlen programmiert. Er diente also nur als Generator einer einzigen Periode eines ummgekehrten Sägezahns von maximaler Amplitude. Diese steuerte, unterschiedlich abgeschwächt und teilweise mit umgekehrtem Vorzeichen, die Tonhöhe mereerer hörbarer Sinusgeneratoren, welche also ein Spektrum bilden, das sich mit falllender Steuerspannung immer mehr zusammenzieht. Darüber hinaus aber steuuerte das digitale Interface einen SYNLAB-Funktionsgenerator, welcher rückgekoppelt die Zeitbasis des digitalen Sequenzers selbst darstellte. So wurde aus der eingegebenen linearen Datenfolge eine exponentielle Kurve. Da in diesen Rückkopplungsweg noch ein von Hand bedienter Schieberegler eingeschleift war, konnte der interpretierende Komponist also die »zweite Ableitung« des letzIich hörbaren Tonhöhenverlaufes global beeinflussen und so den in seiner Grunddstruktur feststehenden Spektralverlauf in seinem konkreten Zeitverhalten interaktiv überprüfen und das jenseits aller Mathematisierbarkeit intuitiv (unter Beerücksichtigung der großformalen Zusammenhänge) als "richtig" erkannte Timing vermittelt und doch unmittelbar realisieren.

|

FEHLT NOCH !! |

| Musikbeispiel 3: Ausschnitt aus "imtakt -- Konzert für Cembalo und Band" |

Ein weitergehender Ansatz zur Ausnutzung der integrativen Kraft der Digiitaltechnik ist der Bau von sog. musikalischen Workstations. Dies sind Systeme, die potentiell alle drei beschriebenen Familien von Satztechniken und Analyseemethoden (mit den Schlagworten bezeichnet »voltage-control«, »musique conncrète« und »Serialismus«) in einer einzigen Maschine realisieren können, konntrolliert mit den gleichen Sprachmitteln. Eine solche Workstation ist z.B. das AUDIAC-Projekt.

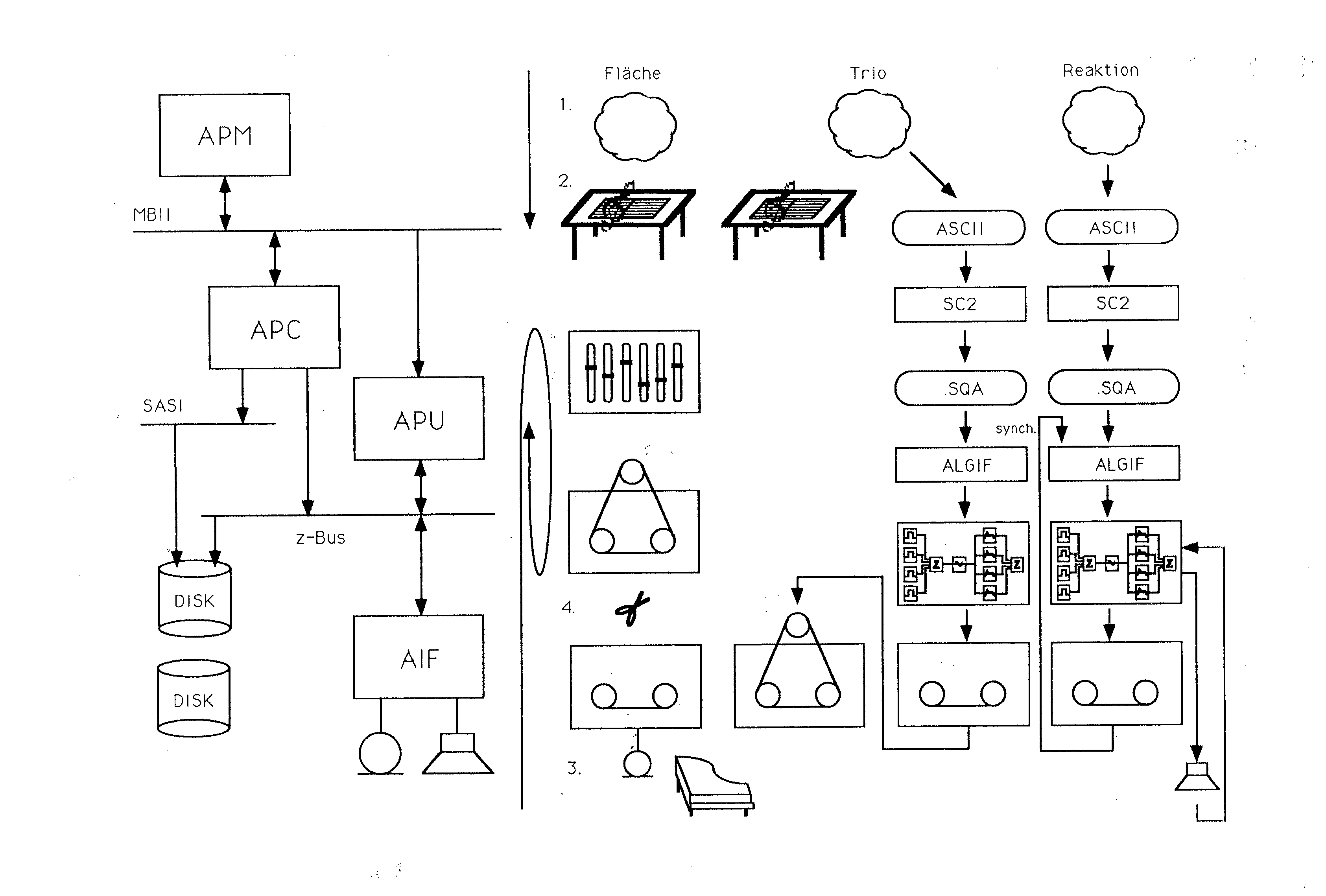

Als Beispiele diene der erste Satz meines Werkes »imtakt, Konzert für. Cemmbalo und Band«. Dieses entstand bis zum Jahre 1986 im alten "Elektronischen Studio der Folkwang-Hochschule" mit der dort installierten hybriden Technoloogie von Analogsynthesizer, digitalen Programmen und Sequenzer und Banddschnittverfahren. Als Exposition eines achtsätzigen Konzertes beinhaltet der erste Satz fast alle damals zur Verfügung stehenden Technologien, welche in den Folgesätzen jeweils einzeln analysiert werden. Ich werde kurz die Entstehung der einzelnen Materialschichten dieses Satzes darstellen, um dann zu vergleichen, an welchem Ort innerhalb der Architektur des rein digitalen AUDIAC-Systems die einzelnen Produktionsschritte heutzutage stattfänden. Eine graphische Übersicht davon findet sich in Abbildung 6.

|

| Abbildung 6: Produktionsprozesse für den ersten Satz von "imtakt --- Konzert für Cembalo und Band". |

Der Satz besteht aus drei in größerem Abstand nacheinander einsetzenden Schichten,

genannt »fläche«, »Trio« und »Reaktion«. Die »Fläche« besteht aus

einhunderttfünfundzwanzig überlagerten Tonbandschleifen mit konkretem,

eingespieltem Cembalo-Material. Fünfundzwanzig Motive wurden eingespielt

und zu Tonbanddschleifen geklebt. Jedes dieser Motive wurde einzeln für

sich fünf verschiedenen Tonbandtranspositionen unterworfen. Der Inhalt der

Cembalomodelle sind sequenzierende Figuren, die im Gestus den Bachschen

Sequenzmodellen nachhempfunden sind, jedoch real statt tonal sequenzieren.

Die endgültige Lage im Tonraum aber, also auch die Dichteverteilungen der

Töne und die Regeln der Bandtransposition wurden errechnet nach einem

Material-Zitat aus O. Messians seeriellem Klassiker »mode de valuers ... «.

Das sog. »Trio« besteht aus einem einnstimmigen Cembalopart, in dem die

demselben messianschen Werk zugrundelieegenden drei Reihen von

Tonnamen/Tondauer-Paarungen so umsortiert wurden, daß ihre Abfolge

ebenfalls Bachschen Motiven ähnelt. Diese Cembalostimme wird ergänzt zum

Trio durch zwei computergenerierte Stimmen, die das Cembalo von rechts und

links zunehmend in die Zange nehmen. Diese beiden vom Commputer generierten,

rechnerisch transponierten und exakt gespielten Vor- und Nachhechos werden

ergänzt durch transponierende Vor- und Nachechos höherer Orddnung, die mit

Tonbandtechniken und Harmonizer-Transposition erzeugt wurden.

Die am Schluß einsetzende Schicht »Reaktionen« färbt die Töne der Cemmbalostimme ab und besteht einerseits aus Liegetönen, die die schwarzen Tasten des Cembalos in der klassischen »Fallparabel« darstellt, andererseits aus Immpulsen, die senkrecht zur bisher dominierenden Richtung in den Raum wanndern. Der Rhythmus dieser Impulse ist durchaus irrational zum Restrhythmus und wurde vom digitalen Sequenzer generiert, die Hüllkurve, die die Raumbeewegungen steuert, wurde im Analogrechner mit ADSRs generiert und nach geehörpsychologischen Kriterien von Hand eingestellt (qua akustischer Kontrolle der Raumwahrnehmung und Extrapolation auf größere Volumina).

|

FEHLT NOCH !! |

| Musikbeispiel 4: Aufführungsmittschnit "imtakt --- Konzert für Cembalo und Band", Folkwanghochschule 1990, Solist Harald Opitz |

Betrachten wir in Kürze die einzelnen Produktionsschritte dieser drei Schichten und ihre Orte im Studio:

Für die Schicht »Fläche« wurden die Schleifenmodelle für die Cembalospielungen und die Transpositionsregeln vom Komponisten auf dem Papier errrechnet; eine Notenvorlage für den Spieler geschrieben; die einzelnen Sequenzzmodelle aufgenommen; die Bandaufnahmen per Tonbandtechnik zu Schleifen geklebt und transportiert; der Verlauf der Großform (also die schrittweise Aussdünnung) gemäß dem vorher berechneten Plan am Mischpult durch multiplay-Bandtechniken geregelt.

Für die Schicht »Trio« wurde der dreistimmige Satz konstruiert; einerseits die Partitur von Hand geschrieben; andererseits eine ASCII Datei erzeugt, aus der das Programm SC2 eine Steuerdatei für den »digital-nach-analog« Sequenzer errzeugt hat; dieser steuerte dann die Klanggenerierung im Synlab-Analogrechner, deren Ergebnis mittels Bandtechniken und Harmonizer mit transportierenden Vor- und Nachechos versehen wurde.

Für die Schicht »Reaktion« wurden die Zeitverhältnisse, Bewegungsrichtunngen, Tonraumdispositionen etc. »im Kopf<, berechnet; wiederum eine ALGIF-Datei erzeugt, welche die Rhythmen der einzelnen Schichten beinhaltet; und dann im multiplay-Verfahren jede Tonhöhe einzeln auf das Band gebracht, wobei einerseits die bereits fertige Aufzeichnung der Trio-Schicht zum Zwecke der Synchronisation den Sequenzer steuerte und das Mithören im Raum dem Kommponisten erlaubte, die Hüllkurven der Raumwanderungen seinen Wahrnehmungen und Extrapolationen folgend einzustellen.

Das AUDIAC-System nun besteht aus verschiedenen hochspezialisierten Subsystemen. Alle diese werden jedoch durch eine einheitliche Bedienoberläche angesteuert und sind qua intelligenter Software dem Benutzer gegenüber »transparent«.

Die Funktionseinheiten sind:

.Alle diese Submoduln können ein- oder mehrfach im System installiert werrden.

In Abbildung 6 bezieht die grafische Höhe (y-Koordinate)

der für imtaktdargestellten Arbeitsschritte sich

auf das Submodul, welches bei einer Neurealisierung auf dem AUDIAC-System

diesen Arbeitsschritt durchführen würde. Dabei ist besonders zu beachten, daß

auch Arbeitsvorgänge, die.damals nur auf dem Papier stattfanden, also die

Vorgänge des seriellen Denkens, die Tonraumdisposition, Dauern-berehcnung,

Wertepermutation, Heuristik et . heutzutage durchaus innerhalb des

Rechners ablaufen können, also qua definiertem "Kompositionsprogramm".

Abgesehen von der durchaus eigenen Problematik der Kompositionsproogramme, ist der Vorteil einer integrierten Architektur wie des AUDIAC-Systems wohl offensichtlich: Die eigentliche Arbeit des Komponisten wird weniger beelastet durch die unterschiedlichen Bedienungsformen, längeren Realisierungsszeiten, verwaltungstechnischen Aufgaben und erleichtert durch den unmittellbaren Zugriff auf alle Datenebenen eines Projektes, welche vorher auf die unterrschiedlichsten Medien verteilt waren.

Der dritte Punkt der Auswirkungen der integrativen Kraft der Digitaltechnik nämlich betrifft genau diese Austauschbarkeit der Datenformate. Eine digitale Steuerzentrale eines hybriden Studios und eine musikalische Workstation errmöglichen nämlich die Anwendung ein und derselben Datenfolge auf verschieedenartige Geräte; die Wiederverwendungvon Daten (wie Frequenztabellen, forrmalen Regeln, Schaltungsdefinitionen) in verschiedenen Projekten und das wechselseitige zur Verfügungstellen von Forschungsergebnissen zwischen Kolllegen und somit den erweiterten Erfahrungsaustausch auf einer objektivierten Grundlage.

Besonders im Falle der Entwicklung von Kompositionsalgorithmen kann es zwar der Fall sein, daß ein Programm schon das Werk ist, also überaus persönliiche und einmalige Strukturmerkmale beinhaltet und nur zur einmaligen Aussführung für genau ein Stück gedacht ist. Jedoch auch der gegenteilige Fall ist häufig gegeben, daß nämlich ein Kompositionswerkzeug so allgemein ist, daß es neben den konkreten ästhetischen Implikationen durchaus verschiedenste Verrwendung finden kann, ja daß der Autor überaus interessiert daran ist, daß Dritte mit seinem Werk Erfahrungen sammeln, ihm davon direkt oder qua musikaliischer Produktion berichten und so sein Produkt einer weitgehenden ästhetiischen Erforschung unterziehen.

Auch dieser Aspekt ist Gegenstand des AUDIAC-Projektes, wobei besonders durch die Entwicklung der Sprache APOS versucht worden ist, den Komponiisten, der ein digitales Programmsystem entwickeln will, zu entlasten von den immmer gleichen Standardaufgaben, Scanner, Parser, Editoren, Ausgaberoutinen und Speicherverwaltungen implementieren zu müssen. Diese Entlastung soll in den nächsten Jahren wesentlich zu einer Förderung des Entstehens von Kompoositions- und Analysealgorithmen beitragen.

Eine zweite Gruppe grundlegender Eigenschaft der Digitaltechnologie, welche der Studioanwendung entgegenkommt, bilden Erweiterbarkeit und Adaptierbarkeit . Diese sind nichts anderes als die »integrative Kraft«, betrachtet aus dem Blickkwinkel eines fertigen systems.

Die Erweiterbarkeit bedeutet, daß neue Geräte und Satztechniken organisch in ein bestehendes System eingefügt werden können, vorausgesetzt alle Schnittstellen sind universell entworfen und sauber ausgeführt.

Die Adaptierbarkeit beinhaltet, daß ein Anwender sowohl in Betracht seiner generellen Vorlieben, Gewohnheiten und Ausdrucksformen als auch in bezug auf eine spezielle Problemstellung, sich seine Arbeitsumgebung, die Kontrolllsprache, die Art der Rückmeldungen vom System etc. jeweils eigen und selbständig konfigurieren können soll. Dadurch wird erreicht, daß der Benutzer, der als realisierender Komponist ja in bestimmten Phasen von Produkten und Abmiischung durchaus in der Rolle des ausführenden Musikers in die metrisch strukturierte ablaufende musikalische Zeit eingebunden ist und zeitrichtig agieren und reagieren muß, ausschließlich die Informationen zugeführt bekommt, die er für eine bestimmte Realzeitphase tatsächlich braucht, und die komplexesten Eingaben mit den physisch einfachsten Aktionen durchführen kann.

Was werden nun die absehbaren zukünftigen Auswirkungen des Einsatzes der Digitaltechnologie auf das musikalische Denken sein (wie im letzten Zweig der Abbildung 4 angedeutet)?

Zum ersten erwarten wir vom systematischen Einsatz der Digitaltechnik, wie schon erwähnt, eine weitgehende Entlastung des Komponisten sowohl von orrganisationstechnischen Nebentätigkeiten als auch von rein technologisch beestimmtem Informationsballast. Zusammen mit dem weniger indirekten Zugriff auf alle an einem Projekt beteiligten Materialien wird dies sowohl zu einer bessseren Ausnutzung der geistigen Kapazitäten in der Produktion führen als auch zu unmittelbareren Ansätzen in der Didaktik der Ausbildung.

Eine weitere neue Quantität, die durch eine integrierte Realisierung der kommpositorischen und klangerzeugenden Ebene erzielt wird, ist die der kürzeren Rückkopplungszeiten zwischen strukturellem Entwurf, datentechnischer Realiisierung, akustischer Realisierung, rezeptiver Kontrolle und der sich daraus ergebenden Korrektur des Entwurfes nebst Wiedereintritt in diesen Zyklus.

Ein Komponist, der aus seinen Vorstellungen z.B. eine rhythmische Formel ableitet oder eine Regel zur Tonraumstrukturierung, diese Regel dann Schritt für Schritt auf dem Papier durchführt und so einen Notentext erstellt, den dann ein Streichquartett zur Ausführung bringt, unterwirft sich dem längstmöglichen Rückkopplungszyklus: Er wird das Produkt seiner Tätigkeit erstmals in der gemeinsamen Probe der vier Musiker äußerlich anhören und so evtl. mit seinen urrsprünglichen Vorstellungen vergleichen können - vorausgesetzt, jeder Musiker hat seinen Part so gut vorbereitet, daß das, was er spielt, dem Notentext entspricht. Wenn dieser Komponist vorher schon den Notentext in ein handelsübliches Seequenzer-Programm eingegeben hat und ihn sich von seinem handelsüblichen Synthesizer vorspielen läßt, so verkürzt sich die Dauer dieses Zyklus. Wenn aber auch die erwähnte Durchführung der strukturellen Formel, also die Erstellung der Notenfolge, auf einem integrierten digitalen System vom Rechner vorgenommen wird, der sie unmittelbar auch zu Gehör bringen kann, so ist die Dauer des Zyklus nur noch bestimmt durch die Rechenleistung des Commputers.

Um Mißverständnissen vorzubeugen: Selbstverständlich ist das Verhältnis von Vorstellung, Komposition und Realisierung, von Fremd- und Eigenwahrrnehmung eines ästhetischen Objektes ein wesentlich komplizierteres als eben dargestellt.

Bei einem Streichquartett z.B. sind die Gegebenheiten von Aufführungspraaxis, Hörerwartung und Spielhaltung besondere in ihrer historischen Dimension konstitutive Fakten, die auf vielschichtige Weise in die Definition des Objektes selbst hineinspielen und vom Komponisten berücksichtigt werden (der vierstimmige Satz als das schlechthinige Modell von Kontrapunkt und Harmonik, das Spätwerk Beethovens, das Frühwerk Weberns, etc.).

Jedoch kann die quantitative Verkürzung jenes Zyldus zu einer wirklich neuen Qualität werden: z.B. einen sechzehnstimmigen isorhythmischen Satz von je 1024 Anschlägen der Dauer ein-hundertachtundzwanzigstel bei Tempo 60 nach einem bestimmten Zufallsalgorithmus ausführen zu lassen, welcher bestimmte Harmonien vermeidet, andere zu Beginn erlaubt, später verbietet und z.B. am Schluß in ein Unisono mündet, ist natürlich per selbstvereinbartem Regelsystem, stundenlangem Auswürfeln, säuberlichem Notenschreiben und Abbspielen durch 16 technisch hochqualifizierte Streicher durchaus möglich. Will ich aber überprüfen, welche Unterschiede im Erscheinungsbild des Satzes sich bei anderen Zufallsfolgen ergeben, also, wie genau meine Regeldefinition meine Vorstellung beinhaltet, oder will ich ausprobieren, wie die Änderung eines einnzigen Parameters in meinem Regelsystem auf die Wahrnehmung des Satzes sich auswirkt, so müßte ich mehrere Wochen würfeln, viele Notenblätter beschreiben und bräuchte sechzehn sehr nervenstarke und qualifizierte prima-vista Spieeler, die alle Varianten ohne vorheriges Üben nacheinander abspielten. In der rechnergestützten Realisierung müßte ich im ersten Fall lediglich den sog. Starttpunkt des Zufallsgenerators verändern, im letzteren den Programmtext meines Algorithmus editieren, um sofort die Resultate akustisch verifizieren zu könnnnen.

|

FEHLT NOCH !! |

| Musikbeispiel 5: Aufführungsmittschnit "imtakt --- Konzert für Cembalo und Band", Folkwanghochschule 1990, Solist Harald Opitz |

Fragt sich nun ein in der Rezeption der vor-seriellen Musik geschulter Hörer, was das denn solle, wozu man sechzehnstimmige Sätze, global definierte und dann ausgewürfelte Harmonieverläufe und anderes denn brauche, so ist diese Frage berechtigt, das fragen wir uns nämlich auch! Denn jedes Kunstwerk ist unter anderem ein Versuch der Beantwortung einer dergestaltigen Frage, in Form einer Antwort ex parte post, also: welche wahrnehmungspsychologischen, strukturellen Konsequenzen folgen aus einer bestimmten Satz-, Mal- oder Schreibtechnik und wie reagiere ich als Künstler auf diese Konsequenzen auf stringente Weise, um im Rahmen meiner weltanschaulichen Grundvorstellung ein Object der erfolgreichen öffentlichen Kommunikation zu schaffen, --- ein Kunstwerk.

Durch die Anwendung des Computers werden neue Satzformen überhaupt erst möglich und der Komponist kann auf neuartigen Abstraktionsebenen arrbeiten: sein Ausdrucksmittel ist der Algorithmus, seine Einflußmöglichkeit sind die individuellen, mehr oder weniger tief in ihm verborgenen Parameter, sein Werkzeug ist eine Programmiersprache. Nur letzteres ist wirklich neu: Das barocke und klassische Sequenzmodell z.B., bei dem sich ein Motiv auf die Reise macht durch unterschiedliche Stufen der Tonleiter, ist auch ein genau definierter Algorithmus - und jede Tonstufe ein global eingestellter Parameter, mit dem der klassiische Komponist den Modulationsweg einer Sonatendurchfuhrung oder eines Fugenzwischenspiels extern und nach übergeordneten formalen Kriterien lenkt.

Ästhetische Produktion ist zwangsläufig, auf welcher Ebene auch immer, ässthetischer Fortschritt. Fortschritt jedoch setzt Tradition voraus, auf die er sich abstützt, von der er sich abstößt. Der erfolgreiche Einsatz des Rechners in der Komposition verlangt neue Fähigkeiten beim Komponisten, ohne die alten Errfahrungen überflüssig zu machen. Nur so kann ein angemessener Umgang mit dem neuen Medium erreicht werden, der die neuartigen Gestaltungsmöglichkeiiten von Zeit und Raum als solche begreift und einsetzt. Zum Beispiel die Interraktion eines menschlichen Interpreten mit einem Computersystem, welches »in Realzeit« während der Aufführung auf den Interpreten reagiert und Daten generiert und abspielt, auf die seinerseits der Interpret reagiert, ist eine neuartige musikalische Situation, die unter anderem eine praktische Analyse von Zeitwahrrnehmung beinhaltet und neuartige Spannungsverhältnisse zwischen Auditorium, Interpret und Partitur hervorruft.

Der Schlußteil der Studio-Produktion von Nahe zu fern, einem Werk von Dirk Reith für Tonband und keyboardspielenden Interpreten, der qua Midi-Keyboard sowohl einen Midi-Synthesizer direkt steuert als auch einen Computer, welcher seinerseits den Synthesizer bespielt, ist ein Beispiel für »Komposiitionsweisen gegen einen Standard« oder zumindest um einen Standard herum. Am Schluß dieses Werkes bestimmt der Keyboardspieler durch die Tasten einer Oktave nicht eine Tonhöhe, sondern die Auswahl aus einer Menge vordefinierrter Schleifenmodelle.

Mit den Schiebereglern an seinem Keyboard, die normalerweise Klangfarbenparameter des Synthesizers regeln sollen, bestimmt er die Länge der Schleifenausschnitte, das Tempo ihres Abspielens etc.

Darüber hinaus geht noch ein Zufallsfaktor in die konkrete Gestalt der vom Computer gespielten Muster ein, so daß der Interpret hier wirklich aufmerksam zuhören und auf struktureller Ebene spielen muß, um.den (sehr empfindlichen) Schluß des Werkes bewußt und musikalisch sinnvoll zu gestalten.

In der Tat treffen hier in kunstvollem Meta-Kontrapunkt vier(4) zeitliche Bezugssysteme aufeinader: das auslaufende Tonabandmaterial (errechent durch das Programm PPP von Thomas Neuhaus) hat ebenfalls Schleifencharakter, der sich nach global genau vordefinierten Proportionen langsam ausdünnt. Der Großrhythmus der Ausdünnungszustände ist die oberste Zeitschicht, die vom Komponisten explizit geplant wurde. Die Ausführung der Ausdünnung wurde dem Programm überlassen, bildet also eine Zeitschicht, die sich unter der ersten bewegt. Letztlich jedoch entstand so ein Tonband, welches in jede Aufführung dieselbe Zeitgestalt einbringt. Unabhängig davon spielt am Schluß der Rechner die Schleifenmodelle in einer eigenen Zeitlogik. Der Interpret wiederum (der in anderen Formteilen des Werkes sehr genau an die musikalische Echtzeit gebunnden war) bewegt sich am Schluß, gleichsam befreit, auf einer dem Computer übergeordneten Zeitebene, auf der er global die von Band und Computer zuusammen erzeugten Strukturen beobachtet und, sobald er es für nötig hält, zwar mit einem hohen Maß an Verantwortung, jedoch nicht wie sonst auf die Millisekunde festgelegt, seiner Beurteilung gemäß einen Reglerwert verändert.

Während sich die Midi-Technologie sonst nur schwer in den geschilderten Kontext des »kompatiblen und modularen Studios« einfügt, wurde mit Nahe zu fernein wichtiger Schritt hin zur Integration von »Serialismus«, Spieltechniken und computergesteuerter Echtzeit-Synthese getan.

Zwei Details an diesem Schluß sind beachtenswert:

Die letzten erklingenden Töne sind das wiederholte "fis", also der zur Tonhöhe gewordene diabolus is musica, der materialisierte Widerspruch, und somit das eigentliche primum movensder Musik (z.B. Waldsteinsonate, erster Satz, op.111, letzter Satz, etc.)

Zeitens: Das allerletzte Klangereignis ist, obwohl der Kontext eine gegenteilige Wahrnehmung hervorruft, tatsächlich ein einzelner Sinus : Das Grundmaterial der klassichen additiven Synthese der Analogtechnik ist hier aufgehoben im digitalen Medium.

|

FEHLT NOCH !! |

| Musikbeispiel 6: Dirk Reith: Nahe zu fern, Aufführungsmitschnitt, Solistin Susanne Achilles. |

made

2012-03-07_19h58

by

lepper

on

heine

produced with

eu.bandm.metatools.d2d

and

XSLT